前面我们讲了LLM(大语言模型)的世界知识随着训练存储在Transformers网络中的中后段ChatGPT等大规模预训练模型的世界知识的原理,一般LLM的一次训练需要较高的成本,哪怕是SFT(Supervised Fine Tuning)一次的成本也得十万起,如果我们要保持LLM的知识足够新,就要进行持续不间断的训练,这个不管是从工程架构还是成本角度讲都是行不通的。NewBing、ChatGPT WebPlugin增加的对搜索引擎的使用(联网能力)算作是对知识的一种实时补充,但是传统的搜索引擎依然存在一些问题:

- 检索结果不准确:搜索引擎是侧重于召回率的,检索到的东西准确性以及跟问题的相关性不高(想一下你上次使用搜索引擎查一个问题时耗费了多长时间);

- 检索结果时效性低:一个信息从发布到被搜索引擎发现一般需要十几个小时,无法满足高时效性的知识发现诉求;

- 私有知识无法获取:企业内部的数据或文档都是无法通过传统的搜索引擎检索到的;

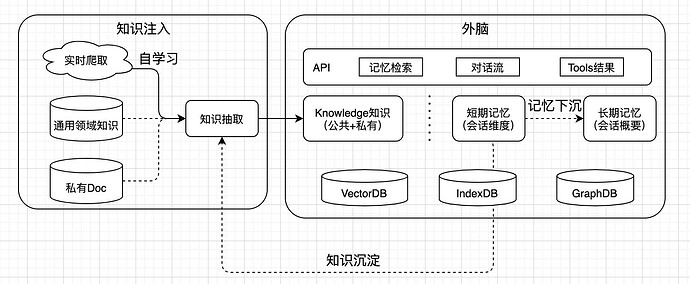

我们提出LLM的外脑解决方案:

这里知识的来源包含几个部分:

- 基于特定知识类网站的实时爬虫爬取

- 特定领域的通用百科知识

- 企业内部的私有文档知识

- 基于用户的对话流做的知识抽取下沉